ALBO TO JA

W dzisiejszym dynamicznym świecie online istnieje ogromna liczba stron internetowych i treści do zindeksowania. W dodatku stale pojawiają się nowe. Jest to główny powód tego, że roboty wyszukiwarek miewają problemy z ich indeksowaniem. Będąc właścicielem witryny, możesz im w tym pomóc – optymalizując witrynę w odpowiedni sposób. Z tego wpisu dowiesz się, czym jest crawl budget i jak go sprawdzić na swojej stronie. Możesz też przeczytać, co wpływa na crawl budget i w jaki sposób można go zoptymalizować.

Spis treści

- Crawl budget – definicja

- Jakie czynniki wpływają na crawl budget?

- Crawl budget – jakie ma znaczenie dla właścicieli stron?

- Co wpływa na częstotliwość wizyt robotów?

- Jak sprawdzić crawl budget na naszej stronie?

- Jak można poprawić crawl budget na stronie?

- Podsumowanie

Crawl budget – definicja

Crawl budget oznacza limit czasu i zasobów, jakie wyszukiwarka przeznacza na proces przeszukania, a następnie indeksowania danej strony. Jest to suma dwóch kluczowych czynników: częstotliwości crawlingu i jego głębokości.

Częstotliwość crawlingu oznacza liczbę żądań, jakie robot wyszukiwarki kieruje do strony w określonym czasie. Natomiast głębokość dotyczy poziomu zagłębienia się robota w strukturę witryny, a mówiąc prościej – ile stron zostanie przeszukanych. Celem tych odwiedzin jest aktualizacja indeksu.

Należy on do jednego z kluczowych czynników, które mają wpływ na indeksację stron internetowych. W efekcie wpływa też pośrednio na pozycjonowanie strony w wynikach wyszukiwania.

Crawl budget jest określany przez wyszukiwarki. To właśnie od danej wyszukiwarki zależy, ile stron jest w stanie zindeksować i jak często będzie to robić.

W związku z tym musimy zwracać uwagę na to, aby strony były odpowiednio zoptymalizowane. To z kolei umożliwi jak najlepiej wykorzystać dostępny crawl budget.

Jakie czynniki wpływają na crawl budget?

Wśród najważniejszych czynników znajdują się:

- duplikacja treści – nie powtarzamy zawartości treści na stronie. W takiej sytuacji roboty marnują czas na przeszukiwanie stron, które już zostały zaindeksowane. Musimy pamiętać o używaniu tagów kanonicznych, czyli linkujących do oryginalnej wersji serwisu, nie do kopii,

- wielkość witryny – jeśli strona posiada dużą liczbę podstron i treści, robot wyszukiwarki potrzebuje więcej czasu i zasobów, aby je przeszukać i zindeksować. Większy rozmiar strony może wpływać na ograniczenie crawl budgetu,

- plik robots.txt – za jego pomocą kontrolujemy, które z naszych stron mogą (a nawet powinny) odwiedzać roboty wyszukiwarki. Nasz sukces zależy od odpowiedniej optymalizacji tego pliku, czyli nie możemy blokować dostępu do stron, które są dla nas ważne. Z indeksowania wyłączamy jedynie nieistotne strony,

- popularność – strony, które są często linkowane przez inne witryny, są też bardziej atrakcyjne dla robotów wyszukiwarek,

- linkowanie wewnętrzne – jeśli jest prawidłowo przeprowadzone, ułatwia robotom znalezienie najistotniejszych podstron w serwisie. Powinno być ono zaplanowane i przejrzyste, dzięki temu efektywność indeksowania będzie większa,

- struktura witryny – jeśli jest jasna i logiczna, ułatwia robotowi wyszukiwarki nawigację po stronie. Jeśli strona ma skomplikowaną lub nieoptymalną strukturę, robot może mieć trudności w przeszukiwaniu wszystkich ważnych stron, co może ograniczyć crawl budget,

- częstotliwość aktualizacji – jeśli strona regularnie publikuje nowe treści lub aktualizuje istniejące, roboty wyszukiwarek mogą zwracać większą na nie uwagę i częściej je przeszukiwać. Regularne dostarczanie świeżych treści może wpływać na zwiększenie crawl budgetu,

- kody odpowiedzi serwera – serwery muszą zwracać odpowiednie kody. Wiele z błędów na stronie sprawia robotom problemy, np. pojawiający się kod 404 prowadzi do tego, że poszukują one stron, które nie istnieją. W takich sytuacjach należy zrobić odpowiednie przekierowanie na inny adres. Jeśli witryna zawiera wiele błędnych stron, roboty wyszukiwarek mogą mieć trudności w jej prawidłowym indeksowaniu,

- wydajność serwera – jeśli nasz serwer działa wolno, to Google będzie rzadko odwiedzał daną stronę.

Crawl budget – jakie ma znaczenie dla właścicieli stron?

Powody, dla których crawl budget jest ważny dla każdej strony:

- efektywność indeksacji – crawl budget to limit czasowy i zasobowy, który roboty wyszukiwarek (takie jak Googlebot) mają na przeszukiwanie Twojej strony. Optymalizacja crawl budgetu umożliwia robotom skupienie się na najważniejszych i najbardziej wartościowych stronach Twojej witryny. Dzięki temu indeksacja Twojej witryny jest bardziej efektywna, a ważne treści są szybciej odkrywane i uwzględniane w wynikach wyszukiwania,

- wydajność strony – jeśli roboty wyszukiwarek poświęcają zbyt wiele czasu na przeszukiwanie nieistotnych stron lub napotykają błędy 404 czy też inne problemy, może to wpływać na wydajność całej strony. Optymalizacja crawl budgetu pomaga usunąć te przeszkody, co przekłada się na lepszą wydajność witryny,

- aktualizacje i nowe treści – jeśli na Twojej stronie regularnie pojawiają się nowe treści (lub tylko aktualizacje), to powinno Ci zależeć, aby roboty wyszukiwarek mogły je jak najszybciej przetworzyć i zindeksować. Optymalizacja tego budżetu pozwala na efektywne wykorzystanie dostępnego czasu robotów, aby jak najszybciej odkrywały i indeksowały wszystkie nowe treści. Dzięki temu użytkownicy również je szybciej zobaczą,

- identyfikacja problemów – crawl budget może być również użyteczny do monitorowania i identyfikowania problemów związanych z indeksacją Twojej strony. Korzystając z narzędzi takich jak Google Search Console, możesz śledzić, które strony są indeksowane, a które nie. W ten sposób dowiesz się też, jakie błędy występują na witrynie, które wpływają na opóźnienie indeksowania. To pozwala na szybkie reagowanie i rozwiązywanie problemów, które mogą wpływać na widoczność Twojej witryny w wynikach wyszukiwania. Dowiesz się też, które strony są najczęściej odwiedzane przez roboty, a które rzadziej, dzięki czemu będziesz mógł popracować nad linkowaniem do nich.

Jak widzisz, optymalizacja crawl budgetu jest związana z widocznością stron w wyszukiwarce. Każdy z powyższych czynników przyczynia się do zwiększenia widoczności Twojej strony w wynikach wyszukiwania. To z kolei ma wpływ na efektywność działań SEO.

Poruszając temat optymalizacji strony, zachęcamy też do odwiedzenia wpisu, w którym omawiamy najpopularniejsze błędy pozycjonowania.

Co wpływa na częstotliwość wizyt robotów?

Istnieje kilka czynników, które w połączeniu ze sobą wpływają na to, jak często roboty odwiedzają daną stronę. Należą do nich:

- wydajność serwera – określa szybkość, z jaką serwer przetwarza żądania użytkowników i dostarcza im odpowiedzi. Jest to ważny aspekt nie tylko dla użytkowników, ale też dla wyszukiwarek internetowych. Jeśli mamy słaby serwer, to roboty Google zmniejszają częstotliwość odwiedzin, aby go nie obciążać,

- baza treści – ważne jest zarówno dodawanie nowych treści, jak i aktualizowanie starych. Jeśli często publikujemy treści, to roboty Google już wiedzą, że muszą nas regularnie odwiedzać, aby na bieżąco je indeksować. Podobnie jest w odwrotnej sytuacji, gdy bardzo rzadko coś publikujemy – wtedy Google odwiedza naszą stronę o wiele rzadziej,

- jakość sitemap – pliki z mapą witryny powinny być stworzone we właściwy sposób i zawierać adresy, które powinny zostać odwiedzone. Poza tym każda z nich musi zostać zgłoszona, liczba linków zewnętrznych – linki prowadzące do naszej strony z innych witryn są sygnałem, który skłania Google do częstszych odwiedzin. Najbardziej pożądane są te, które pochodzą ze stron odwiedzanych często przez roboty,

- linkowanie wewnętrzne – przede wszystkim musi być przemyślanym działaniem. Do najważniejszych stron w serwisie powinno prowadzić jak najwięcej przekierowań wewnętrznych, co ułatwi nadanie im priorytetu.

Jak wspomnieliśmy wcześniej, na finalną decyzję dotyczącą częstotliwości odwiedzin strony przez roboty ma wpływ suma tych poszczególnych czynników.

Oznacza to, że jeśli jeden z nich będzie słabszy, to automatycznie sprawi, że obniży się poziom ich wszystkich. Nawet jeśli reszta z nich została świetnie zoptymalizowana.

Dlatego też warto pamiętać, aby pilnować ich wszystkich w równym stopniu.

Jak sprawdzić crawl budget na naszej stronie?

Do sprawdzenia budżetu indeksowania najłatwiej użyć Google Search Console. Aby to zrobić, wchodzimy do panelu Google Search Console.

Następnie w zakładkach po lewej stronie wybieramy „ustawienia”. Po kliknięciu w tę zakładkę wyświetli się okno podzielone na 3 części. Pierwsza z nich dotyczy ustawień ogólnych, druga indeksowania, a ostatnia informacji.

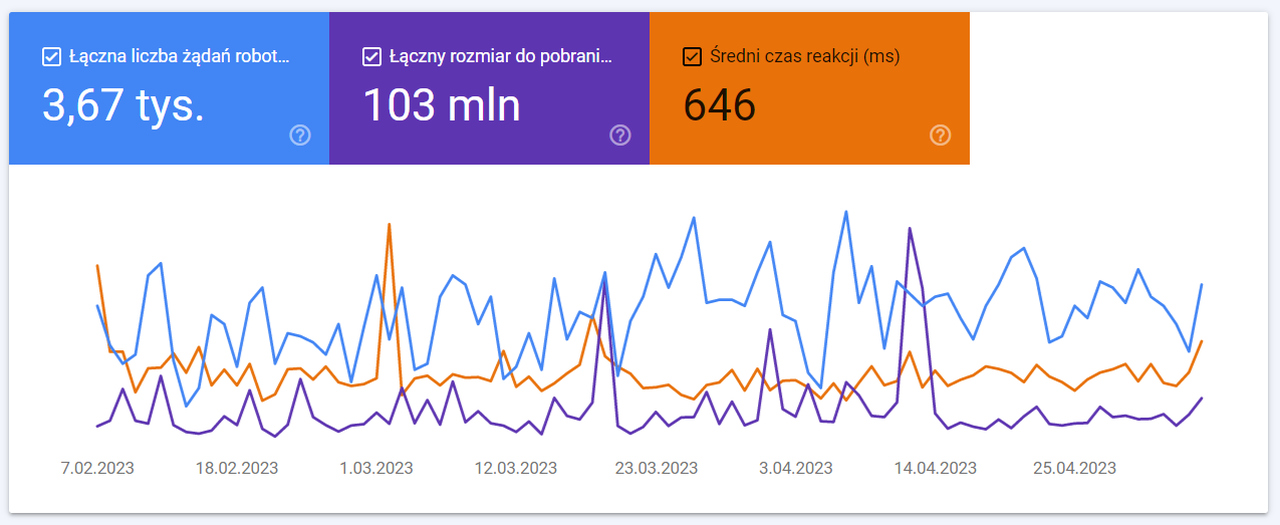

Nas interesuje część poświęcona indeksowaniu, dlatego w statystykach indeksowania klikamy „otwórz raport”. Wtedy powinien wyświetlić się wykres.

Warto zwrócić uwagę na to, że docelowo pokazują się jedynie dane przedstawiające łączną liczbę żądań robotów. Jest to pierwszy z trzech prostokątów na górze tego wykresu. Informuje nas o tym, ile razy nasza strona została odwiedzona przez roboty.

Chcąc zobaczyć więcej danych, wystarczy kliknąć na kolejny prostokąt. Drugi wykres informuje nas o tym, ile danych ze strony udało im się pobrać podczas odwiedzin.

Trzeci wykres przedstawia zachowanie naszego serwera podczas wizyt robotów. Właśnie w tym miejscu możemy zauważyć, jak radzi sobie serwer. Utrzymuje się na stabilnym poziomie czy traci swoją wydajność?

W przypadku drugiej sytuacji możemy to poznać po tym, że wraz ze wzrostem ilości danych pobieranych przez robota, wartość wykresu wzrasta. Pewnie się domyślasz, że dla właściciela strony nie jest to dobra wiadomość.

Co istotne, dane ze wszystkich trzech wykresów mogą wyświetlać się jednocześnie. Każdy wykres ma inny kolor, co ułatwia odczytanie danych.

Jak można poprawić crawl budget na stronie?

Dobrze zoptymalizowany crawl budget może mieć znaczący wpływ na wyniki wyszukiwania. Robot wyszukiwarki powinien być w stanie przeszukać wszystkie ważne strony i treści na naszej witrynie.

Jeśli rzeczywiście tak jest, zwiększa to szanse na to, że nasza strona zostanie zaindeksowana, a następnie wyświetlona w wynikach wyszukiwania.

Ograniczone lub niewłaściwie wykorzystanie budżetu indeksowania może skutkować m.in.:

- pominięciem istotnych stron,

- opóźnieniami w indeksowaniu nowych treści.

Aby zoptymalizować crawl budget na stronie, warto skupić się na następujących aspektach:

- Zadbaj o to, aby serwery zwracały odpowiednie kody.

- Prowadź linkowanie wewnętrzne w prawidłowy sposób.

- Pilnuj, aby nie występowały błędy w tagu kanonicznym, tzw. canonicalu.

- Unikaj zbyt wielu pajęczyn przekierowań.

- Prawidłowo opracowuj sitemapy.

- Odpowiednio korzystaj z pliku robots.txt.

Podsumowanie

Nie każdy zdaje sobie sprawę, że największy wpływ na crawl budget mają właściciele stron. Ich konkretne działania przyczyniają się do tego, że Google postanawia zwolnić lub przyspieszyć proces odwiedzania danej strony.

Warto też pamiętać, że nie mamy możliwości zwiększenia budżet indeksowania, który jest przeznaczony dla naszej strony. Możemy jednak dbać o to, aby był wykorzystywany bardziej efektywnie. I w tym właśnie pomaga odpowiednia optymalizacja.

Dodaj komentarz